Table des matières

Flux - Stable diffusion

Stable diffusion permet de générer des images, open source il permet de générer des images a partir de texte ou d'autres images gratuitement sur un ordinateur offline, il permet aussi de créer des apprentissage pour créer ses propres modèles et générer des vidéos.

Installation

Pour installer SD il faut un ordi récent, Windows ou mac avec une carte graphique adequate >RTX 3070. Il faudra aussi installer Python, Git bash , et télécharger des fichiers assez lourd via HugginFace et d'autres dépots.

Temps d'installation, prévoir 1 à 2 heures de galère potentielle.

- https://pinokio.computer/ Installation facile avec Forge qui installera flux, mais permettera aussi Stable Diffusion en telechargeant des modeles checkpoint

Plusieurs interfaces de contrôle sont disponibles, la plus utilisé se nomme A1111 ou Comfy ui

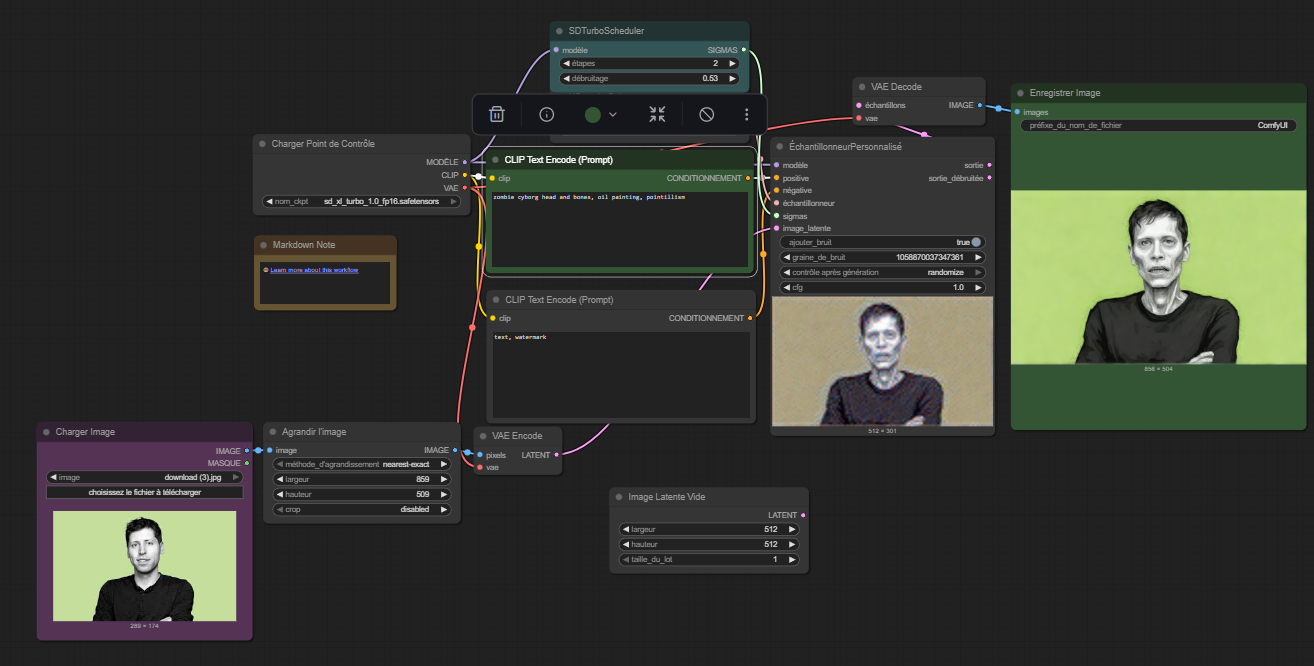

Comfy ui

Page dédiée : ComfyUI

Les modèles d'images

Les modèles d'images (checkpoint) sont des fichiers qui compile des milliers d'image et leurs descriptions, certains sont orienté photo, dessin animé, manga … Un modele est lourd et pese généralement quelques gigas.

- https://civitai.com/ grande source de modele image et video, et lora…

Il y a aussi des modeles pour certains plugin comme controlnet :

Plugins utiles

- Control net

- Dreambooth

- Roop

- Upscaler ..

Flux - skin

Pour rendre plus realiste une image généré par flux. Regenere l'image avec SD (un model special photo realiste) en img2img avec ces parametres :

- Steps: 34,

- Sampler: DPM++ 2M, Schedule type: Karras,

- CFG scale: 7,

- Model: epicphotogasm_amateurreallife,

- Denoising strength: 0.34,

Entrainement avec vos images

Il est possible de creer des LORA pour FLux ou SD.

Via pinokio, l'appli Fluxgym marche bien avec qqs images (entre 5 et 20)

Utilisation dans Forge

Steps: 20, Sampler: Euler, Schedule type: Simple, CFG scale: 1, Distilled CFG Scale: 3.5, Model: flux1-dev-bnb-nf4-v2, Diffusion in Low Bits: Automatic (fp16 LoRA)

Générer des videos

On peut générer des videos ou suite d'images à partir d'une video source et un prompt (texte ou image). Via ComfyUI (sur swarm ui) des workflow avec WAN sont disponible et efficace. (necessite Gpu >12go de Vram)

Kohya-ss install

Attention il faut installer une version python 3.10.9 et click sur add to path ! (eventuellement faire le menage si windows nous force sur une mauvaise version de python ) puis telecharger le git

Extra Links

Control net Guide : https://stable-diffusion-art.com/controlnet/